深度思考大模型API服务deepseek-free-api

简介

这个春节要说最火的,那一定是 DeepSeek 了。

作为一款新兴的 AI 工具,它凭借强大的功能和便捷的操作迅速走红,成为许多人工作和学习中的得力助手。无论是处理复杂任务还是提供创意灵感,DeepSeek 都展现出了惊人的潜力,成为科技圈和大众热议的焦点。

什么是 deepseek-free-api ?

deepseek-free-api是一个开源的API项目,旨在提供对DeepSeek V3 R1大模型的逆向接口,与ChatGPT接口完全兼容。支持高速流式输出、多轮对话,联网搜索,R1深度思考,零配置部署,多路token支持,仅供测试,如需商用请前往官方开放平台。

主要特点

- 高速流式输出:支持快速处理和返回数据。

- 多轮对话:能够处理多轮对话,适用于聊天应用。

- 联网搜索:具备在线搜索功能,增强信息获取能力。

- 深度思考:提供

R1深度思考功能,可以进行更复杂的推理。 - 零配置部署:用户可以快速部署,无需复杂的配置。

- 多路 Token 支持:允许使用多个用户令牌。

该 API 主要用于测试,若需商用则建议前往官方平台进行购买。

在使用

deepseek-free-api前,请仔细阅读并理解官方的免责申明

安装

在群晖上以 Docker 方式安装。

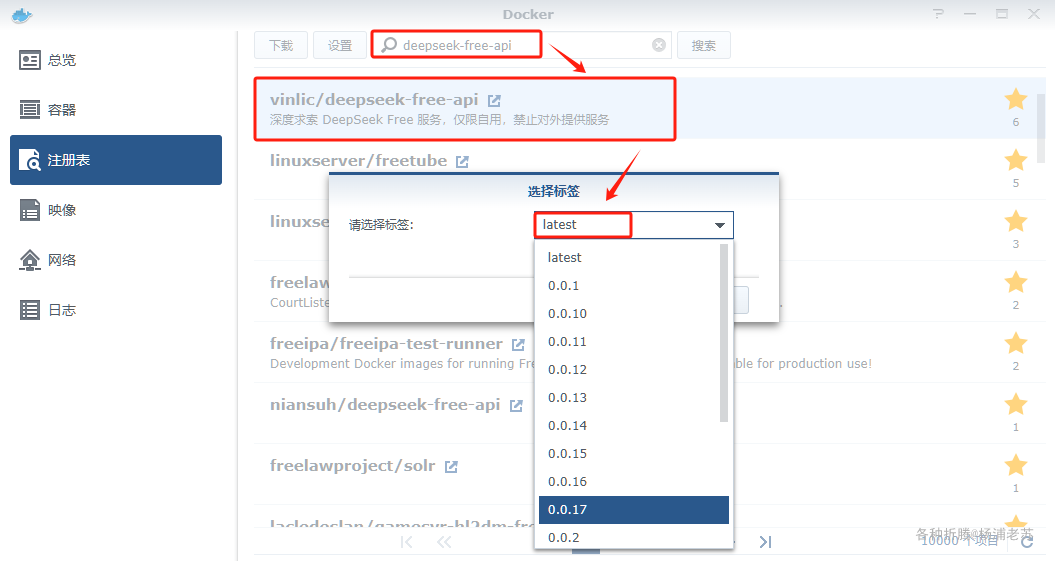

在注册表中搜索 deepseek-free-api ,选择第四个 vinlic/deepseek-free-api,版本选择 latest。

本文写作时,

latest版本对应为0.0.17;

端口

本地端口不冲突就行,不确定的话可以用命令查一下

1 | # 查看端口占用 |

| 本地端口 | 容器端口 |

|---|---|

8127 |

8000 |

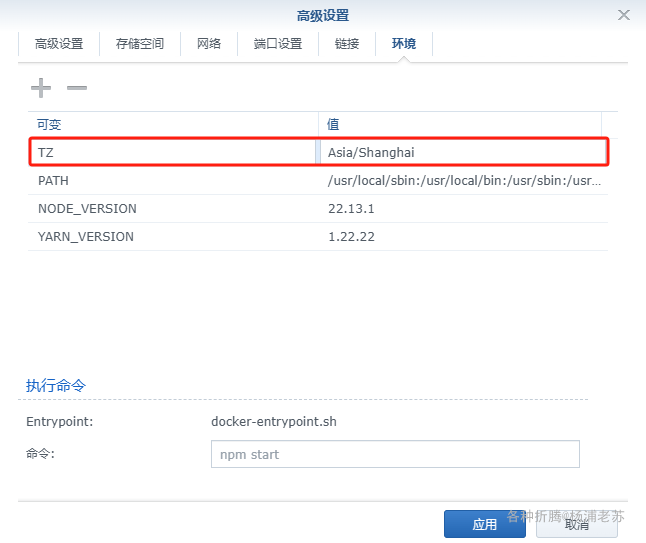

环境

| 可变 | 值 |

|---|---|

TZ |

时区,设为 Asia/Shanghai |

DEEP_SEEK_CHAT_AUTHORIZATION |

userToken 值,这是可选的,未配置则需要在请求头中传递 Authorization |

命令行安装

如果你熟悉命令行,可能用 docker cli 更快捷

1 | # 运行容器 |

--init 标志用于在容器内部启动一个 init 进程。

也可以用 docker-compose 安装,将下面的内容保存为 docker-compose.yml 文件

1 | version: '3' |

然后执行下面的命令

1 | # 新建文件夹 deepseek |

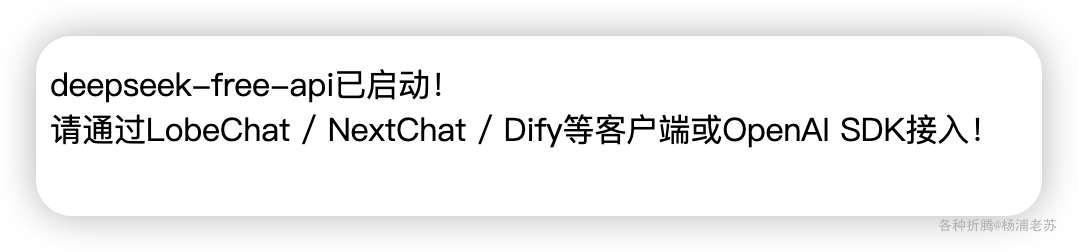

运行

在浏览器中输入 http://群晖IP:8127 就能看到主界面

获取 userToken

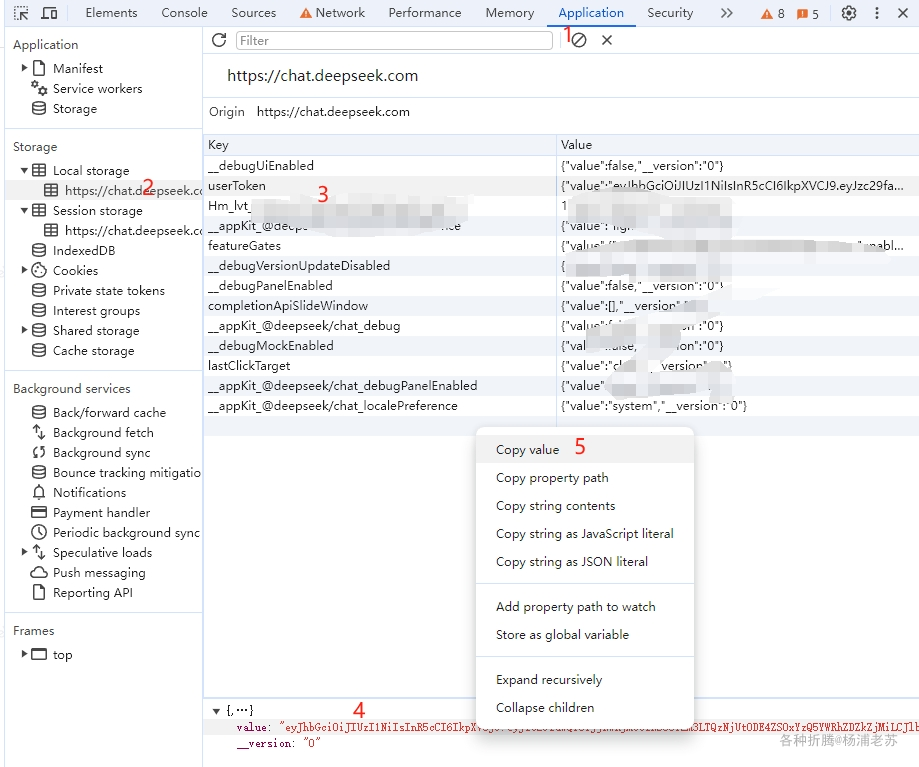

从 https://chat.deepseek.com 页面上获取 userToken

进入 DeepSeek 随便发起一个对话,然后 F12 打开开发者工具,从 Application –> LocalStorage 中找到userToken中的 value 值,这将作为 Authorization 的Bearer Token 值:Authorization: Bearer TOKEN

图片来自:https://github.com/LLM-Red-Team/deepseek-free-api

目前同个账号同时只能有一路输出,你可以通过提供多个账号的 userToken value 并使用 , 拼接提供:

1 | Authorization: Bearer TOKEN1,TOKEN2,TOKEN3 |

每次请求服务会从中挑选一个

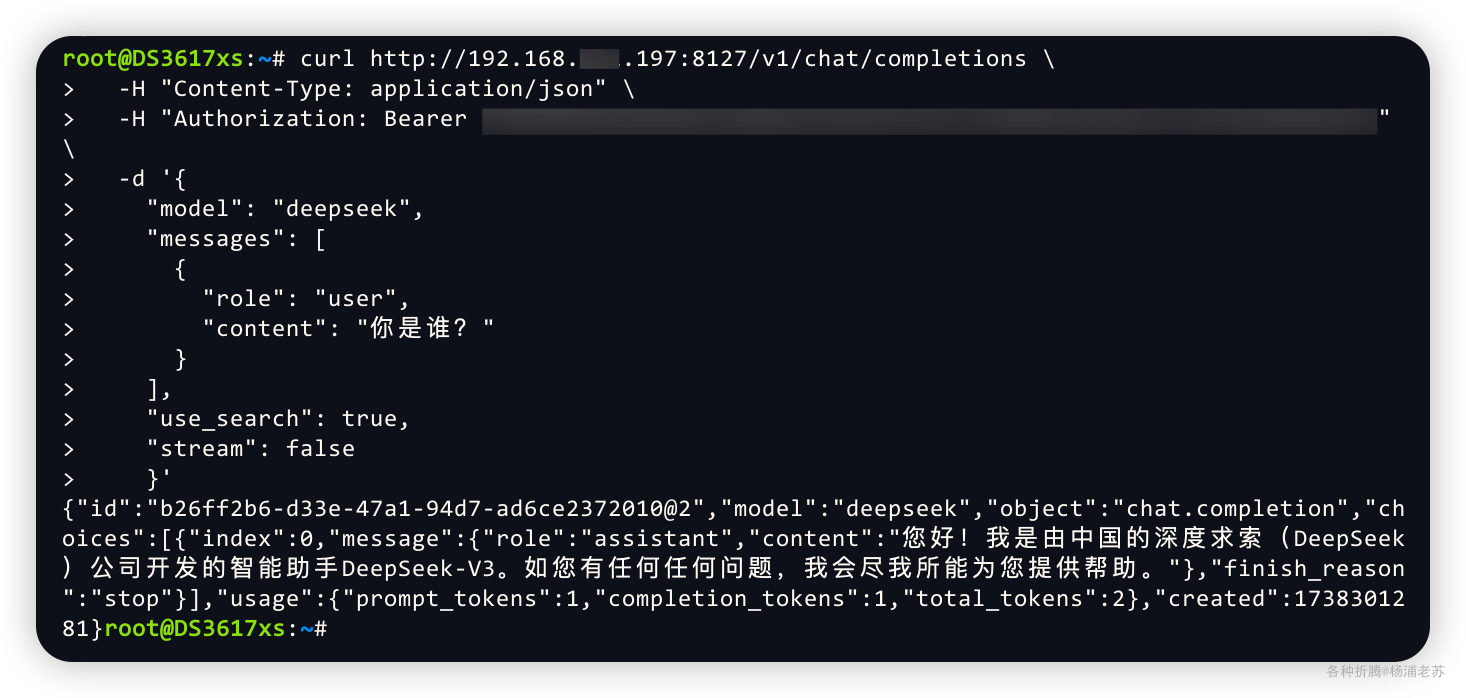

命令行

deepseek-free-api 支持与 OpenAI 兼容的 /v1/chat/completions 接口,所以要验证 API 服务是否正常,可以用下面的示例

用 SSH 客户端登录到群晖后,在命令行执行下面的命令

1 | curl http://192.168.191.197:8127/v1/chat/completions \ |

其中

[userToken]要替换为你前面获取的userToken的值

服务正常的话,很快会得到响应数据

1 | { |

deepseek-free-api 除了对话补全接口,还有userToken 存活检测等接口

推荐使用 API 工具,比如 Postman、Apifox 、ApiPost 等

其他

还可以使用与 OpenAI 或其他兼容的客户端接入接口,例如: ChatGPT-Next-Web

又例如:LobeChat

文章传送门:聊天应用与开发框架LobeChat

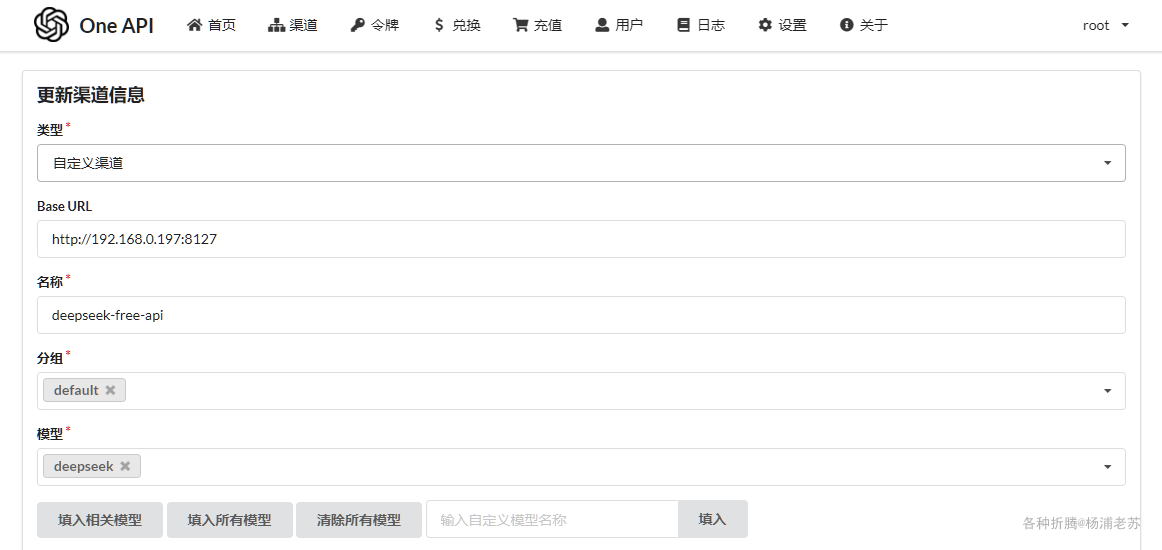

或者接入到 One API 进行统一管理

文章传送门:大模型接口管理和分发系统One API

可能是需要 "深度思考" 的原因,测试时间会比较长

也不排除是因为使用的人太多的缘故

参考文档

LLM-Red-Team/deepseek-free-api: 🚀 DeepSeek-V3 R1大模型逆向API【特长:良心厂商】(官方贼便宜,建议直接走官方),支持高速流式输出、多轮对话,联网搜索,R1深度思考,零配置部署,多路token支持,仅供测试,如需商用请前往官方开放平台。

地址:https://github.com/LLM-Red-Team/deepseek-free-apiDeepSeek - 探索未至之境

地址:https://chat.deepseek.com/