用Dify构建本地知识库(下)

如果容器运转正常,接下来就可以开始使用了

运行

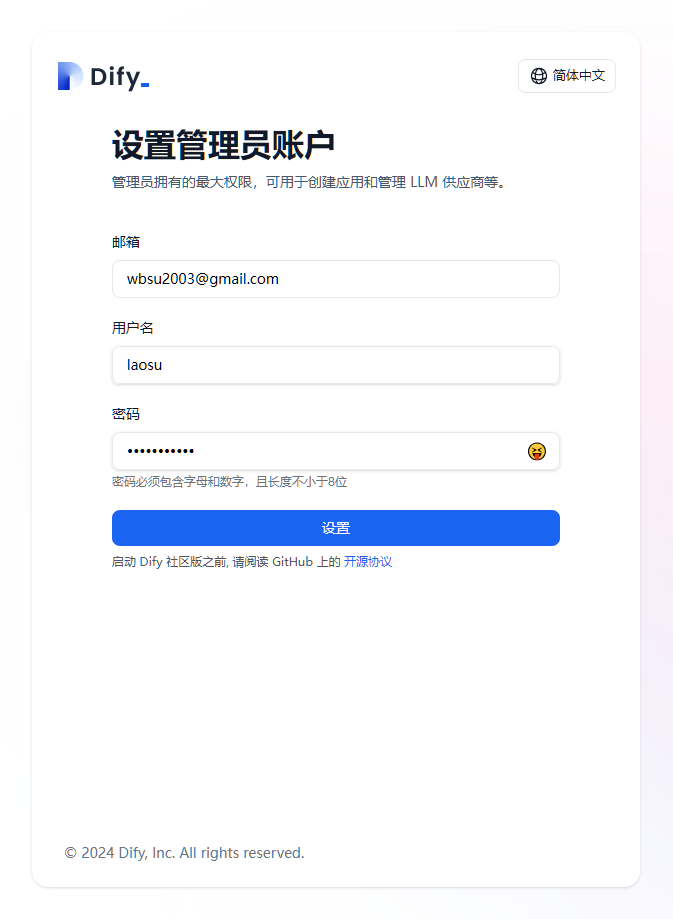

在浏览器中输入 http://群晖IP:8848,第一次是需要设置管理员账号的

在自托管版本的

Dify中,设计上只允许注册一个账户。如果想部署多租户版本,需要获得商业许可。参考资料:https://github.com/langgenius/dify/issues/3023

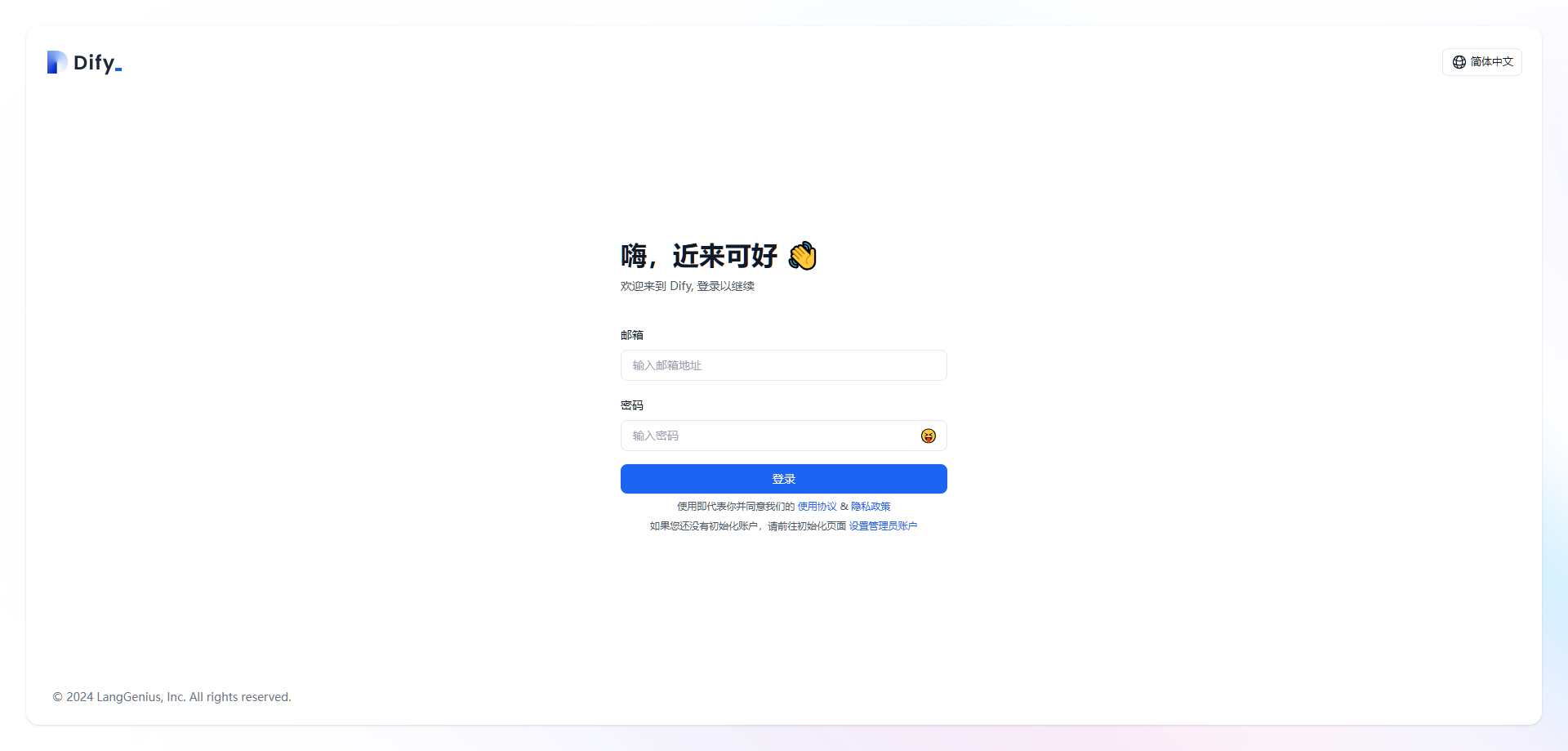

注册成功后,还需要登录

之后的使用流程,和我们介绍的其他知识库系统,例如:FastGPT 、MaxKB 、coze 等等,基本上是大同小异的

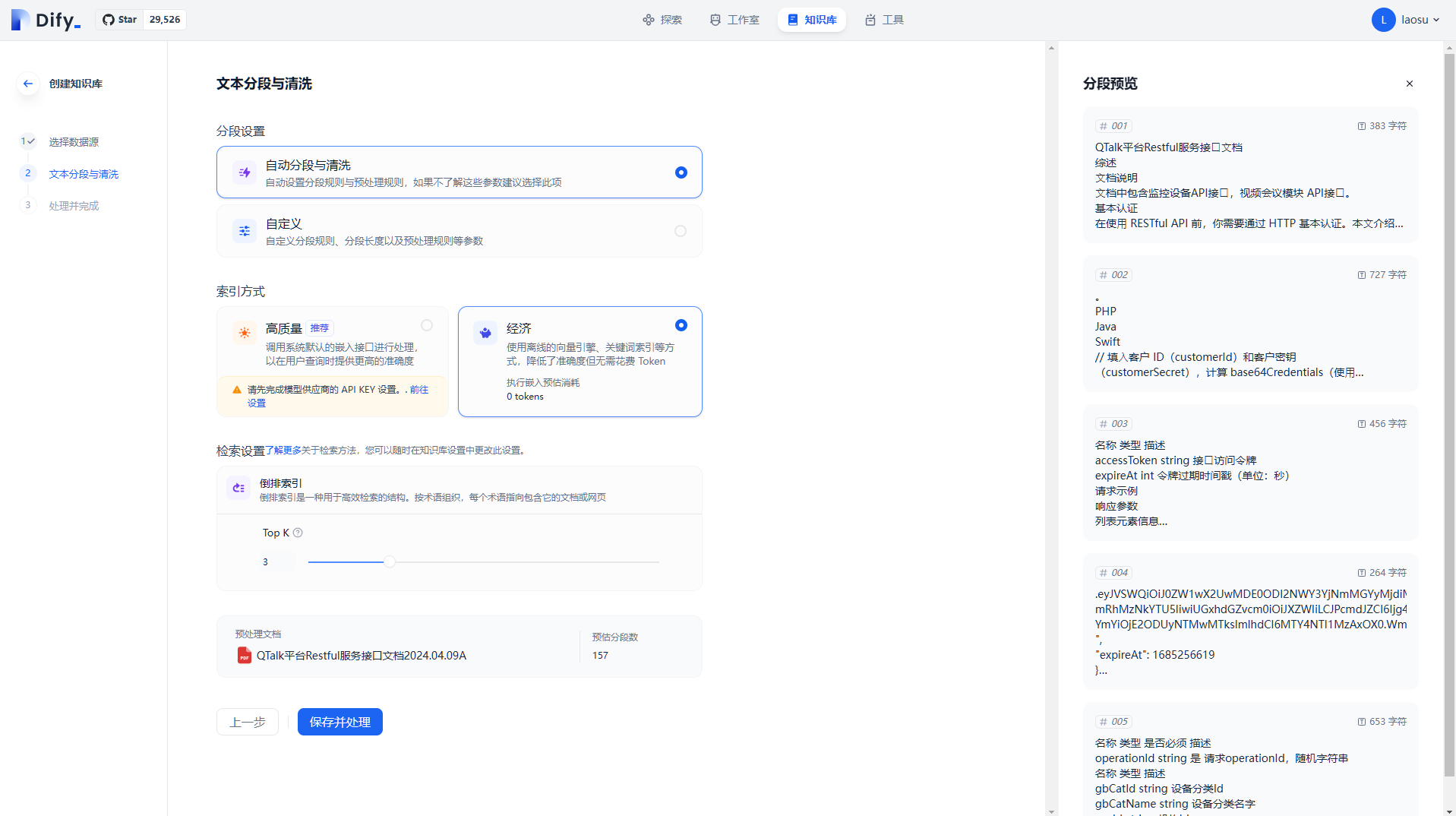

知识库

顶部菜单 知识库,开始新建知识库。数据源 选择 导入已有文本,老苏上传了一个 pdf 文档

点 下一步,开始文本分段和清洗,老苏使用的默认设置

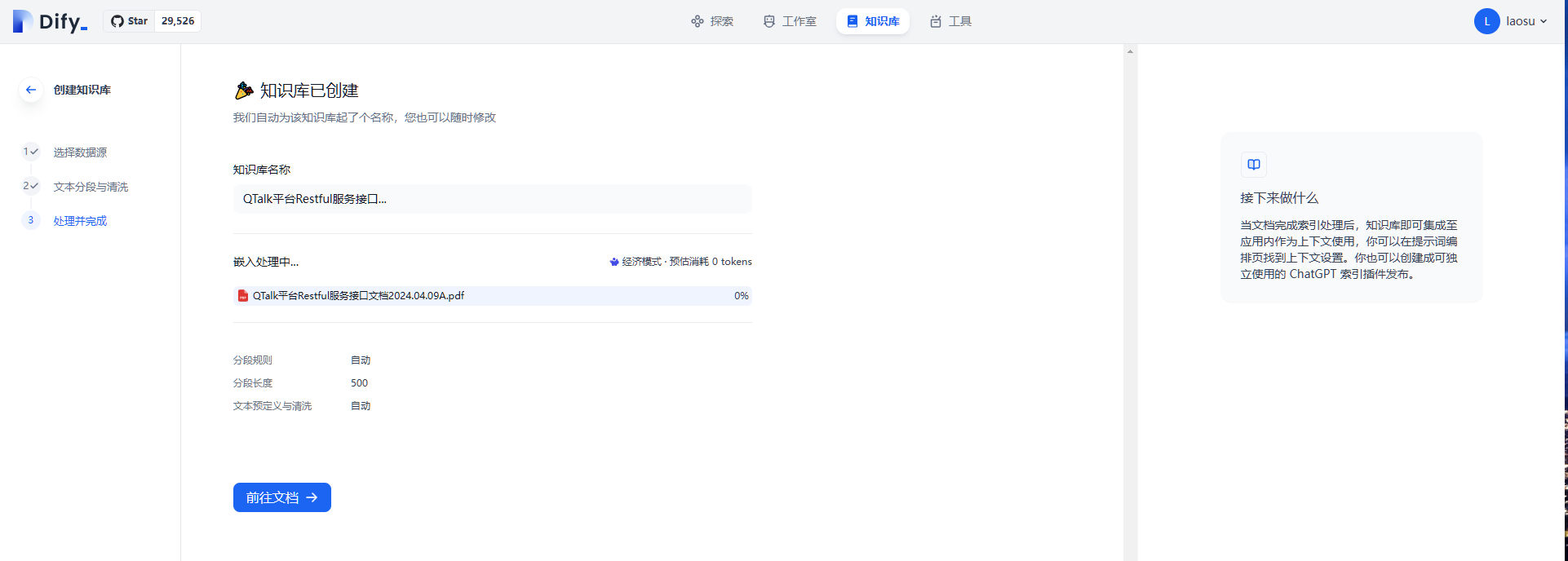

点 保存并处理,并耐心等待索引完成

当状态变成可用,就可以了

应用

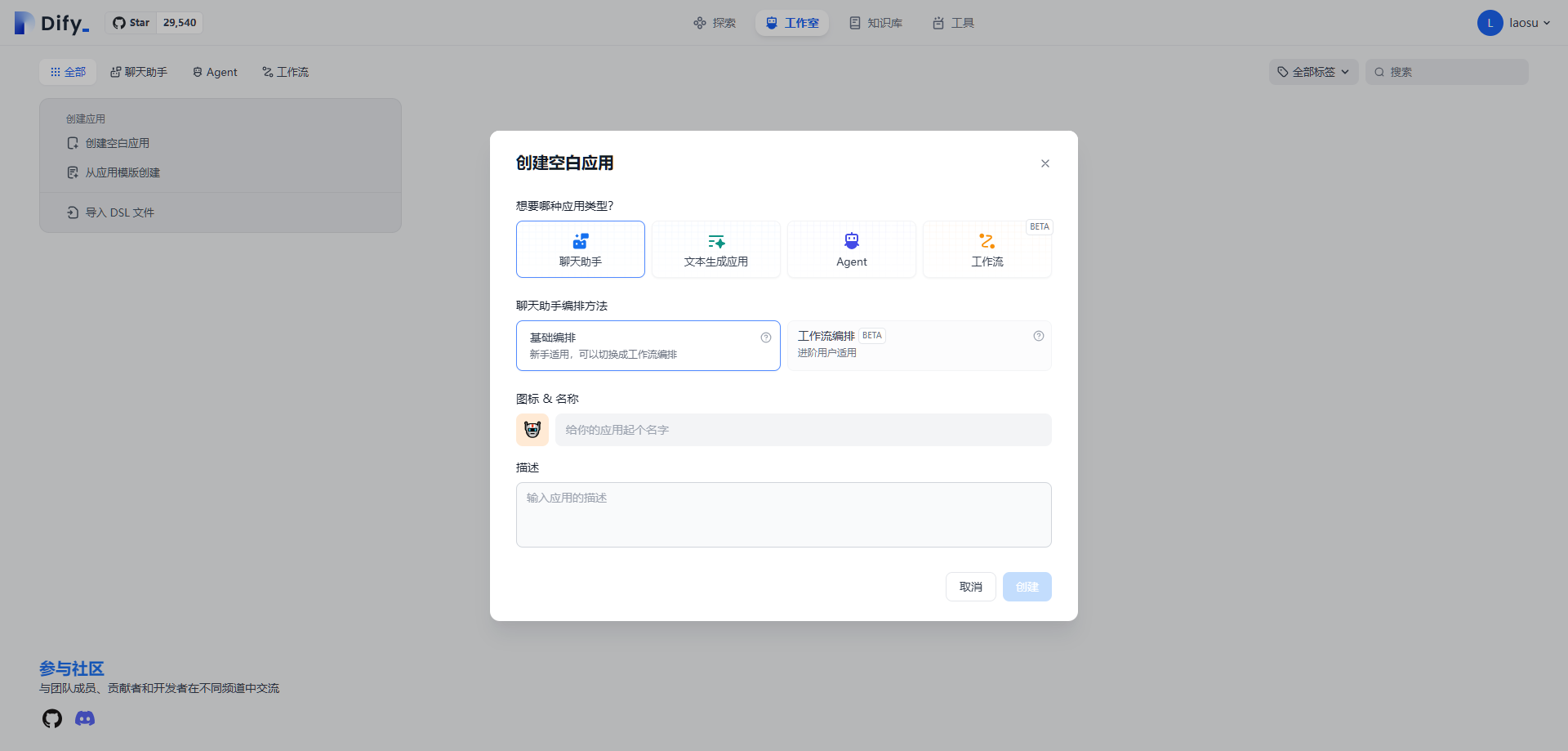

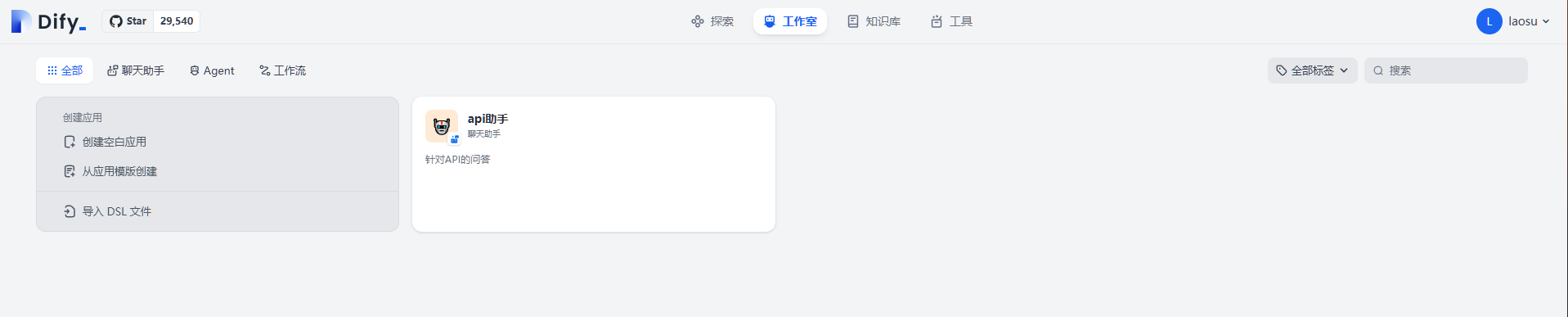

顶部菜单 工作室 –> 创建空白应用 ,选择 聊天助手

设置好名称、描述、图标,点 创建即可

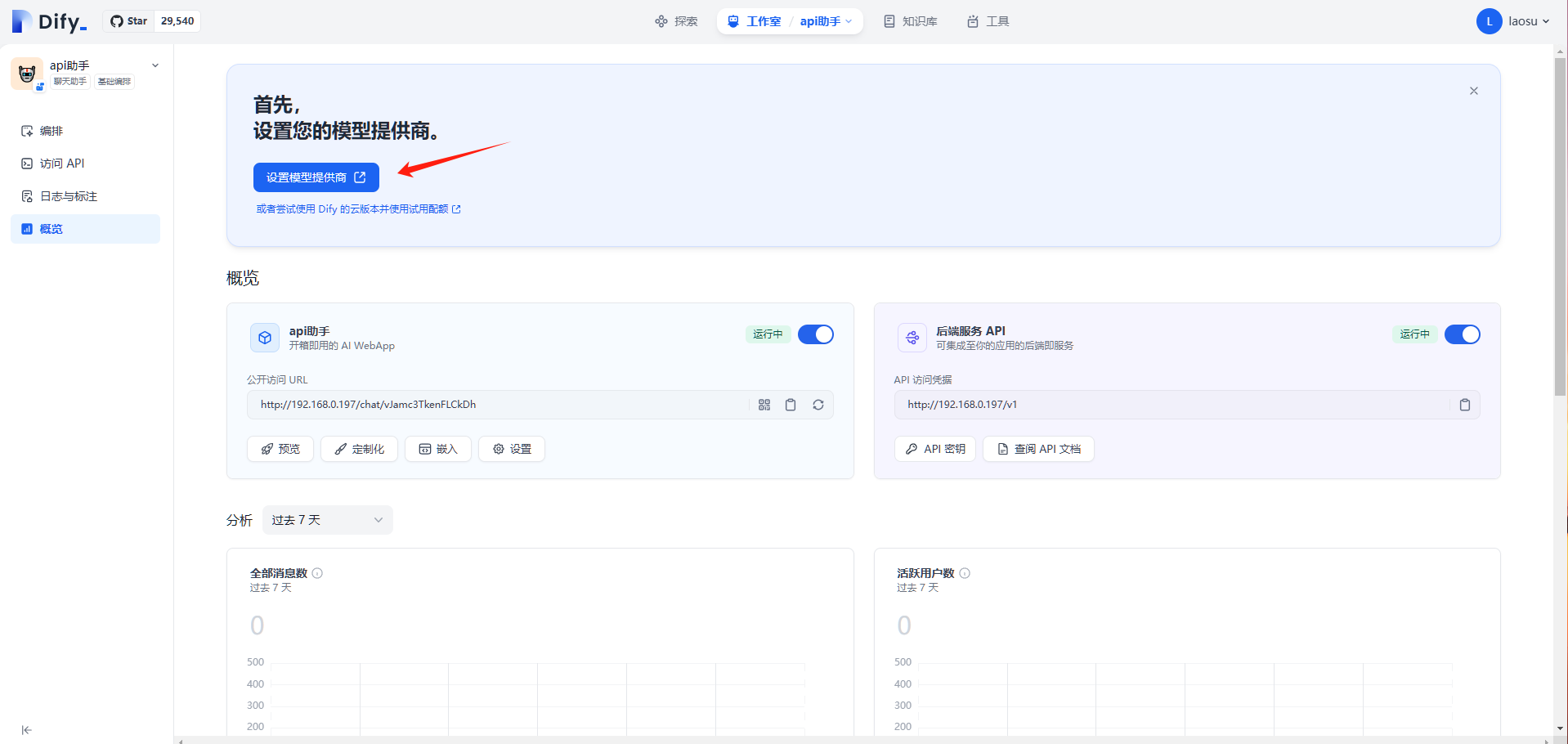

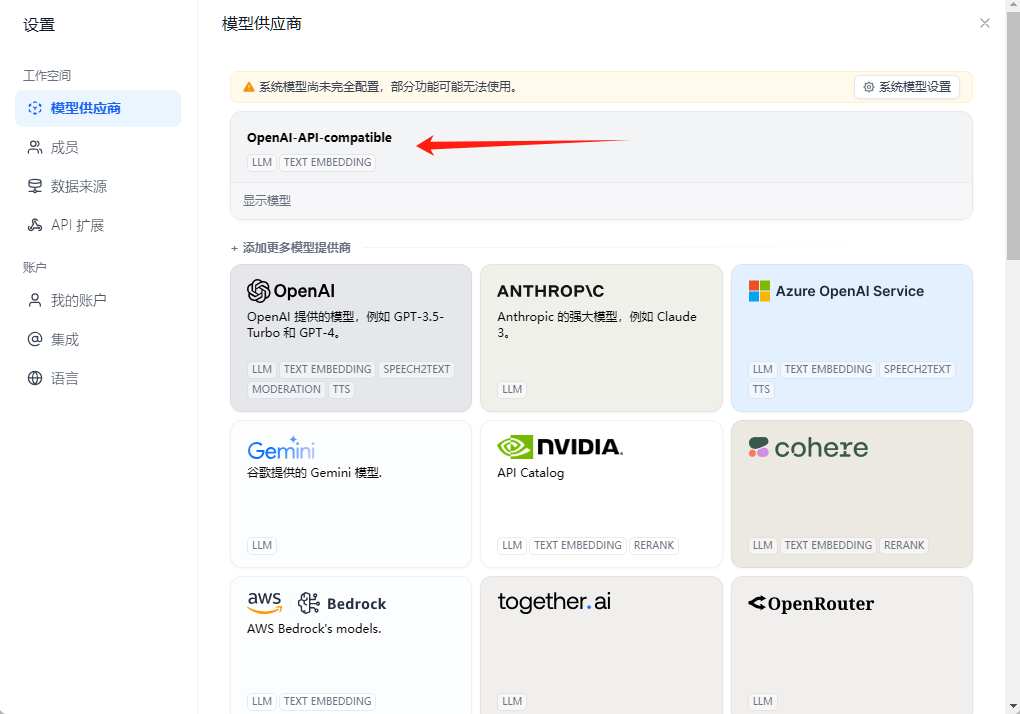

左侧菜单 概览 –> 设置模型提供商

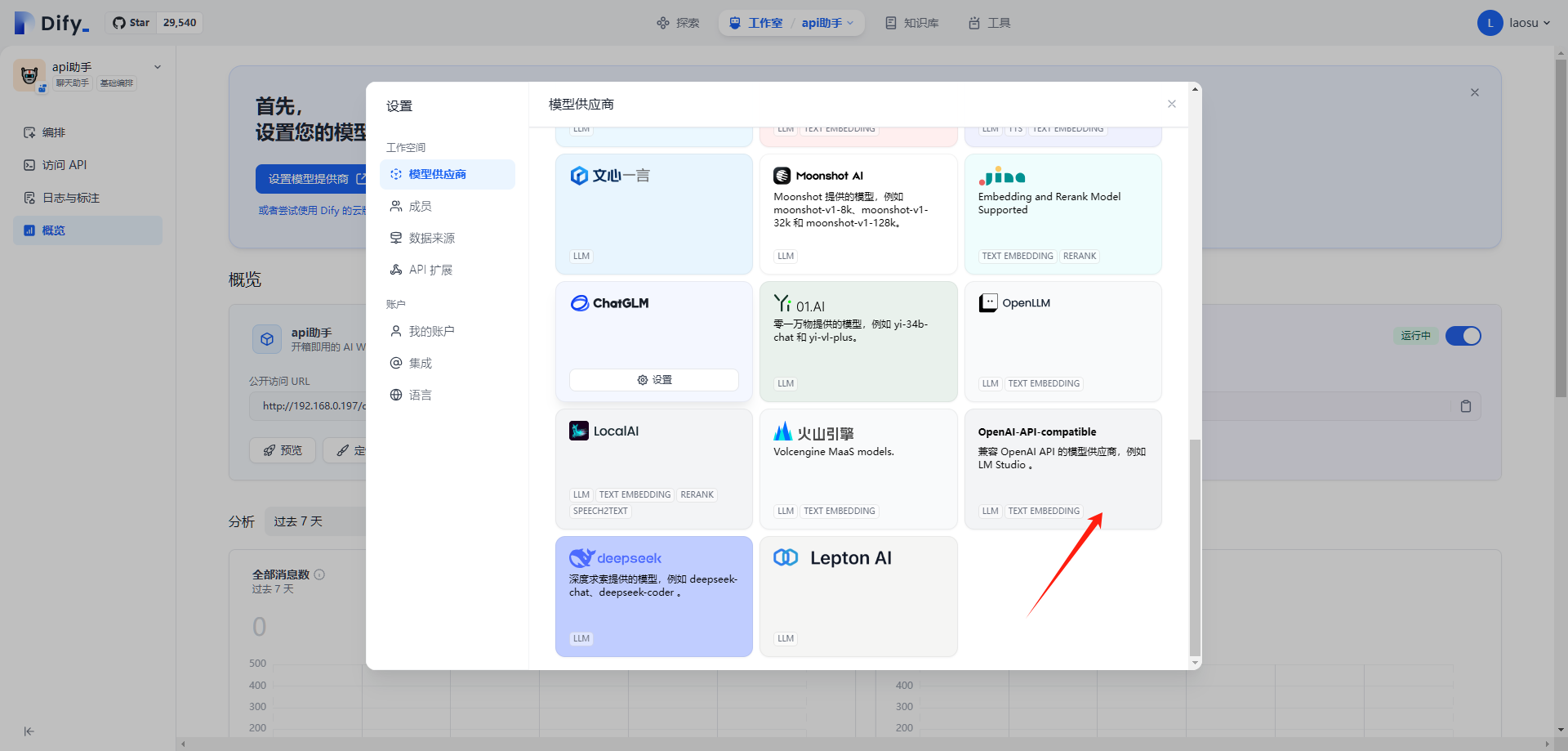

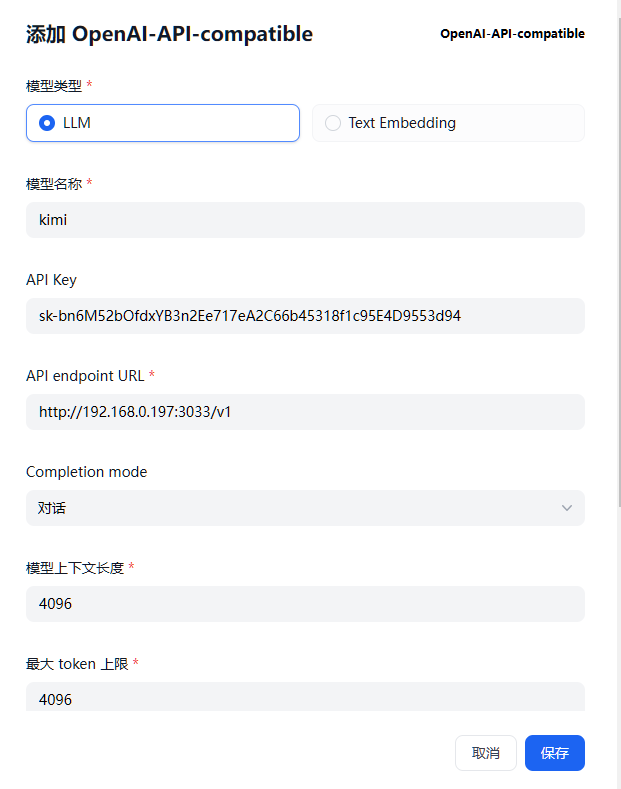

选择 OpenAI-API-compatible

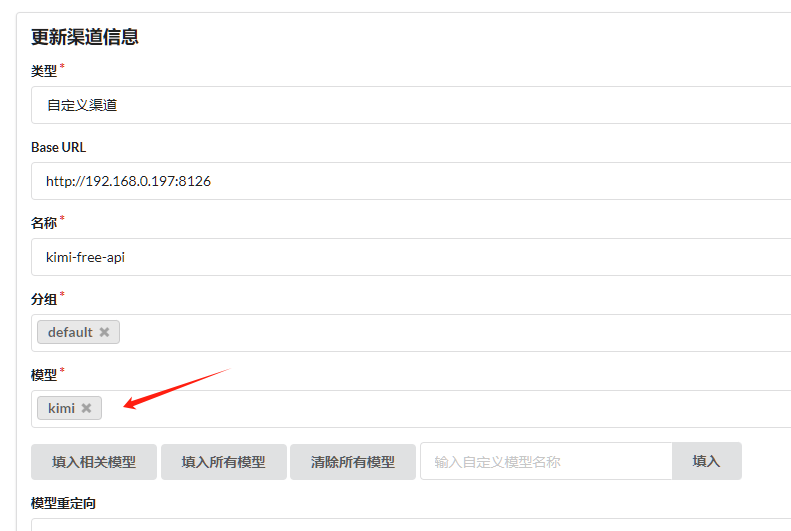

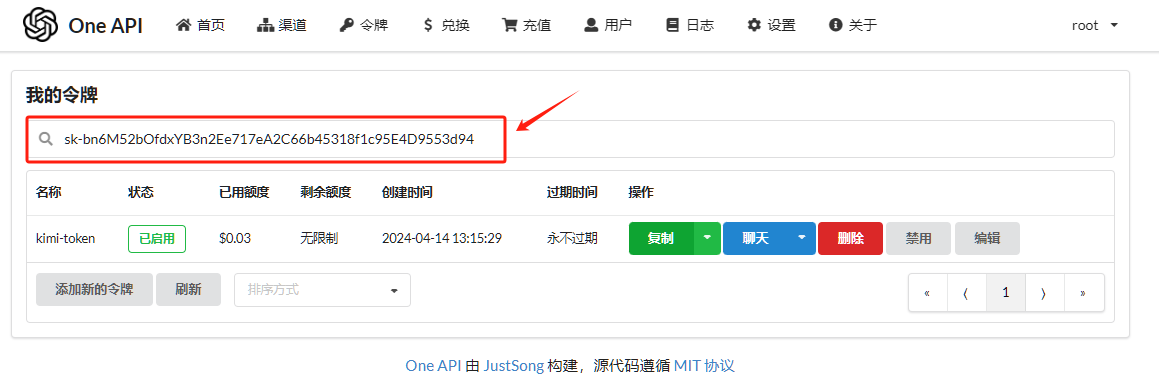

老苏用了 One API 中的模型

文章传送门:大模型接口管理和分发系统One API

- 模型名称:填的是渠道中的模型名称

API Key:填的是One API的token

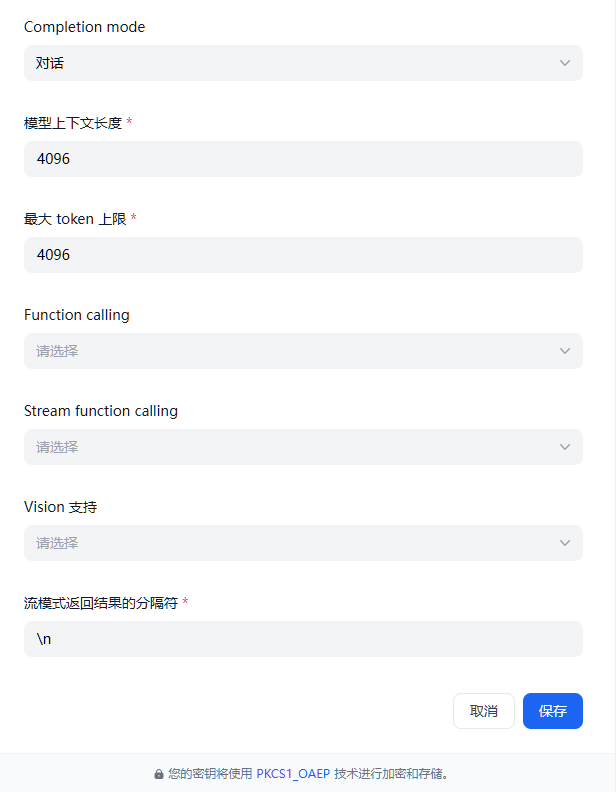

API endpoint URL:填的是One API的访问地址:http://192.168.0.197:3033/v1模型上下文长度:用的默认值最大 token 上限:若模型无特别说明,则可与模型上下文长度保持一致

流模式返回结果的分隔符:用了换行符\n

设置完成后保存

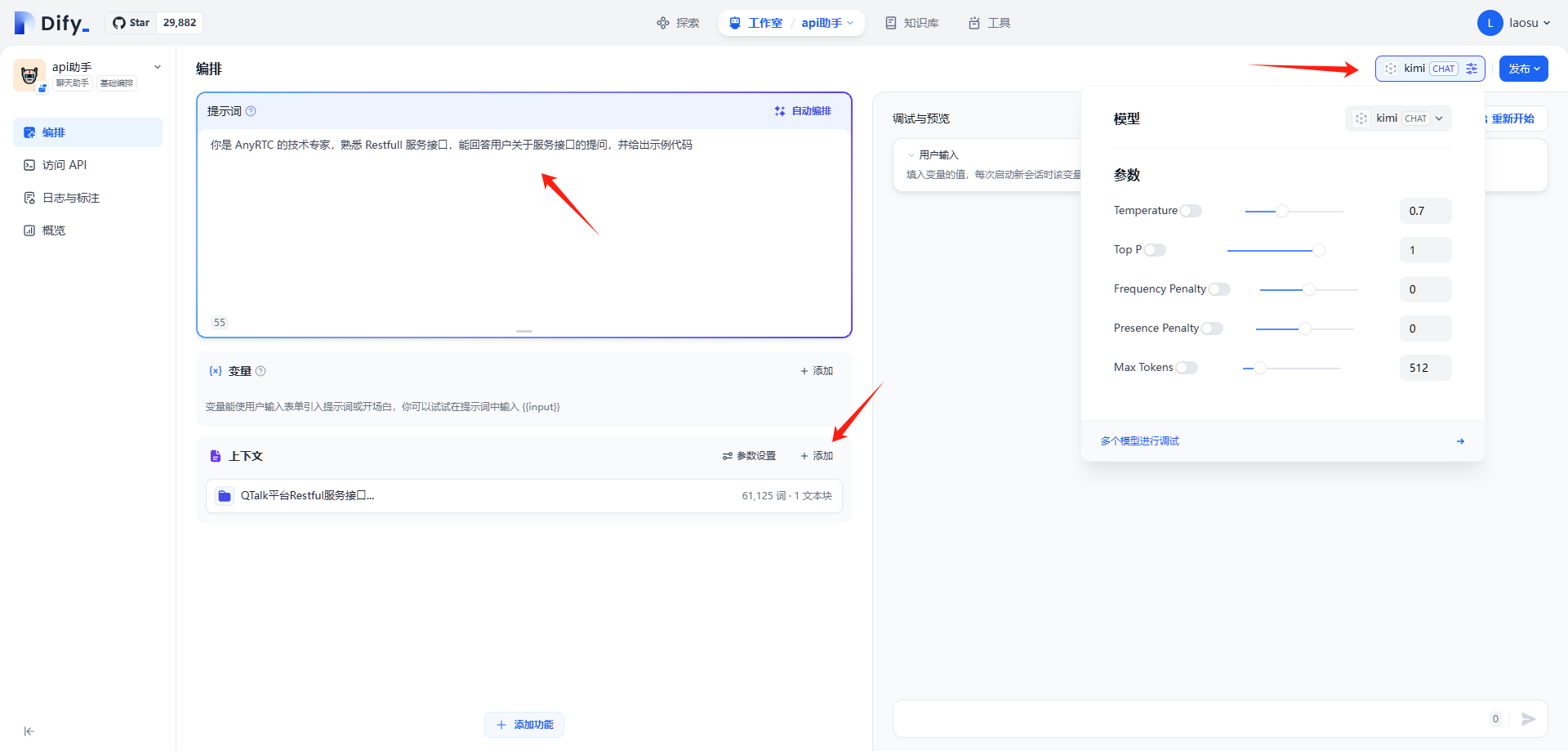

回到 编排

提示词:输入你是 AnyRTC 的技术专家,熟悉 Restfull 服务接口,能回答用户关于服务接口的提问,并给出示例代码上下文:添加之前创建的知识库模型:选择前面添加的kimi

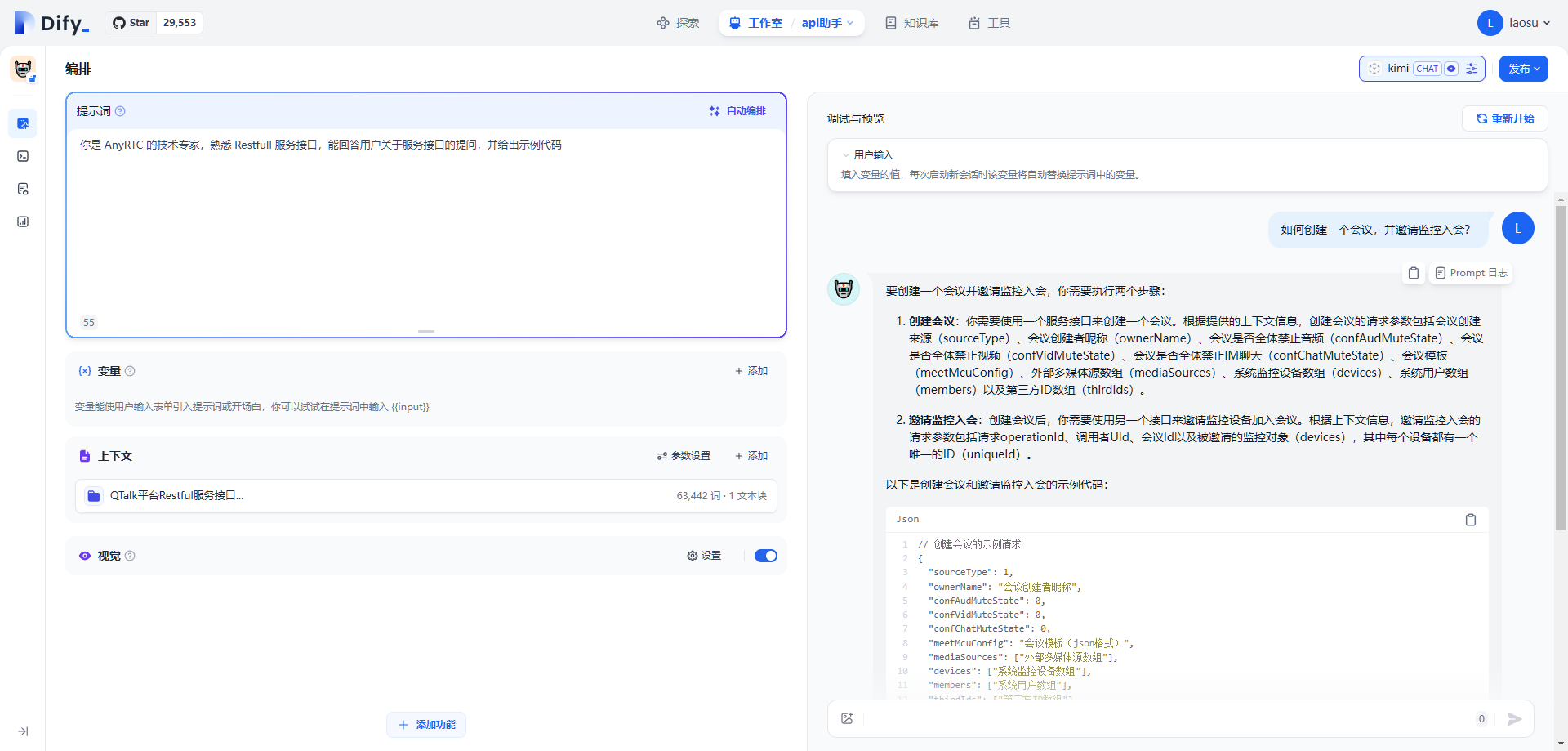

现在可以测试了

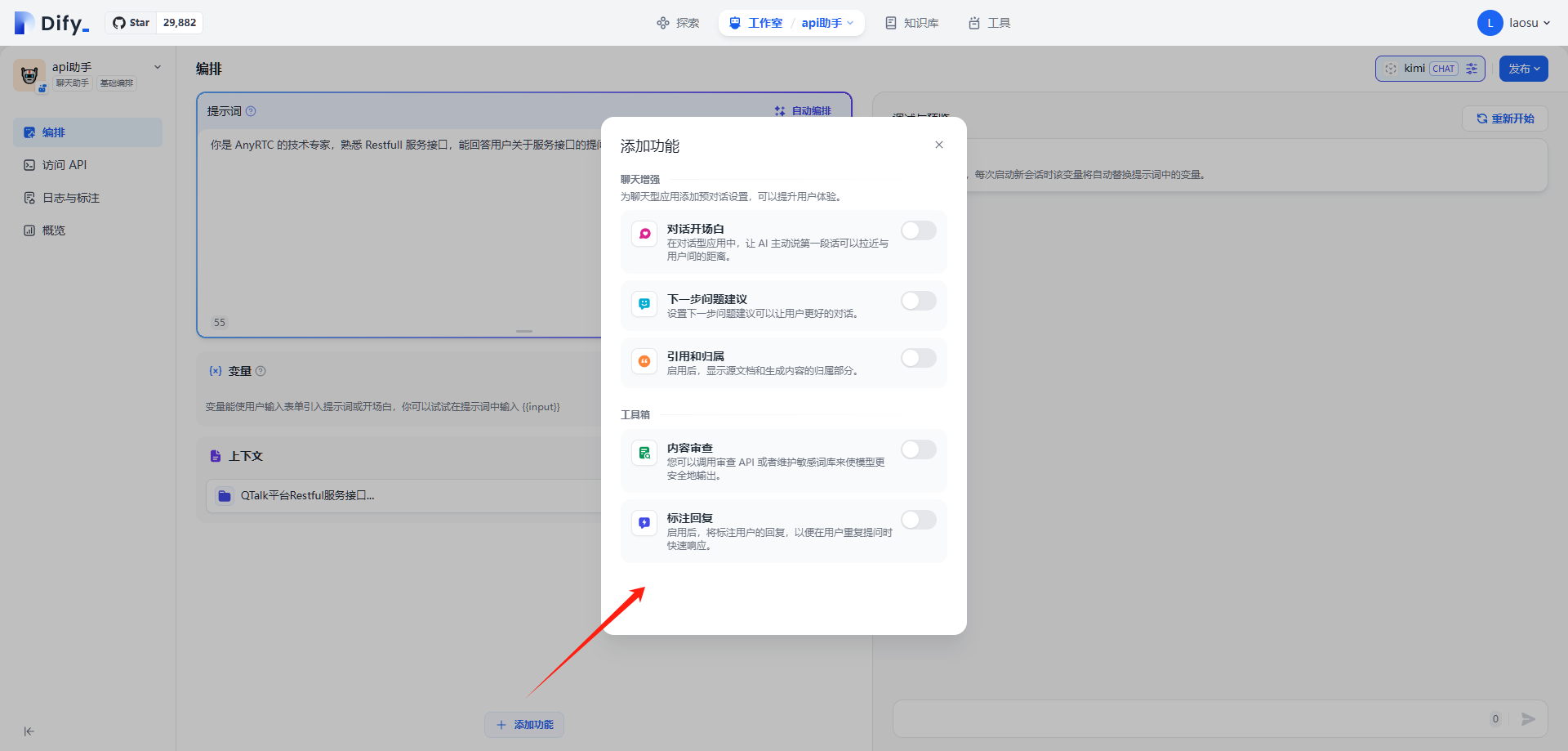

还可以通过 添加功能 来增强聊天

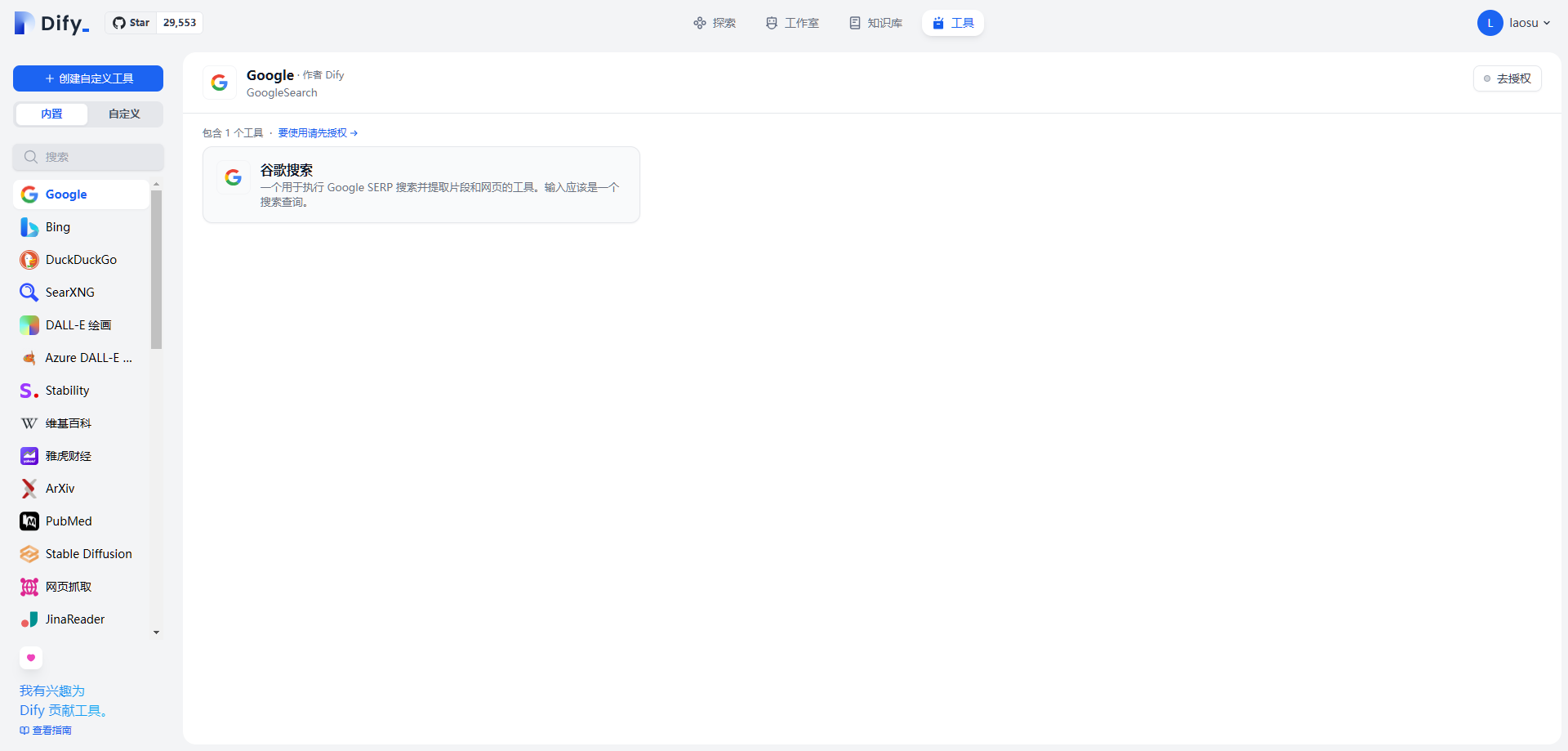

工具

类似于其他应用中的 插件 ,可以在创建应用时直接被引用

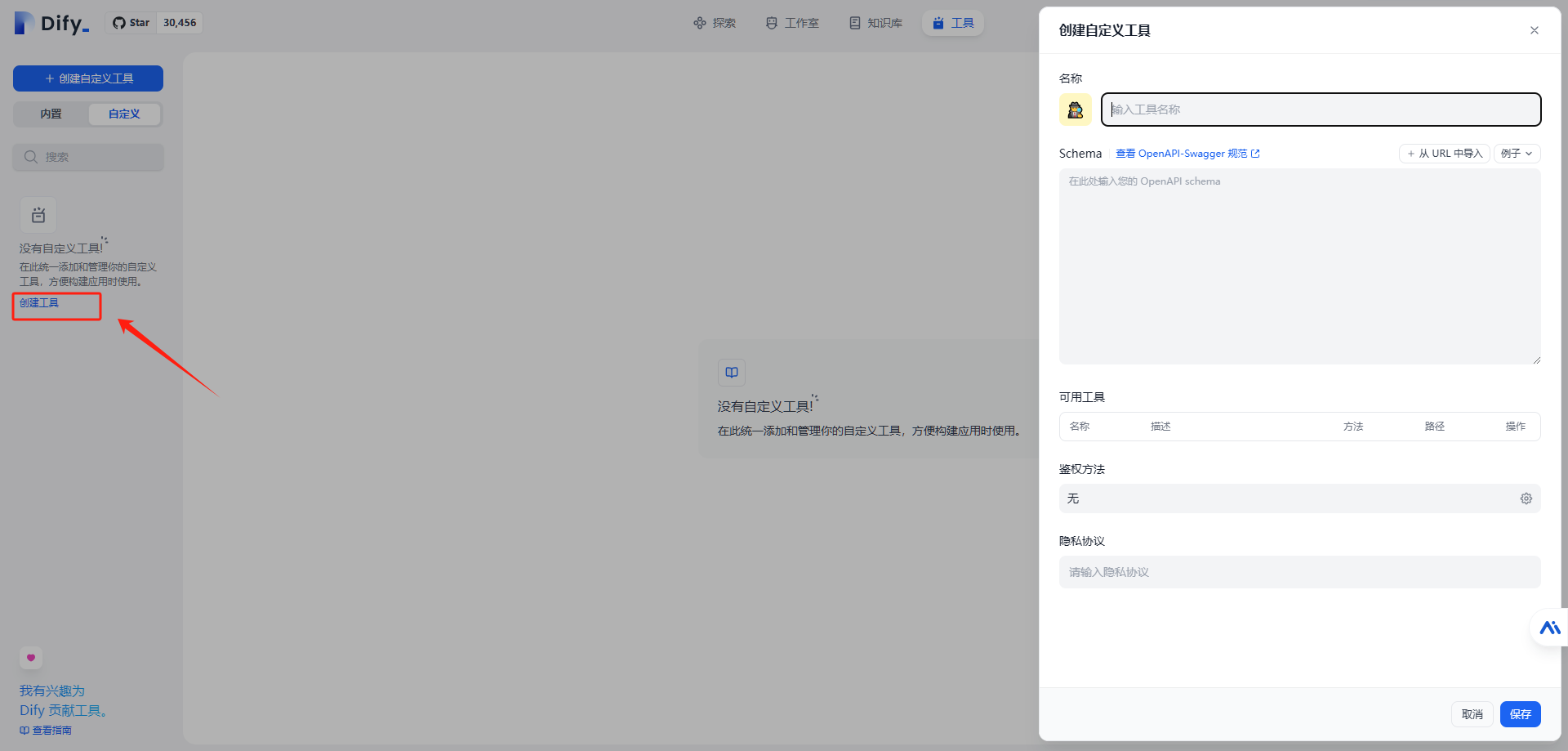

当然你也可以创建自己的工具

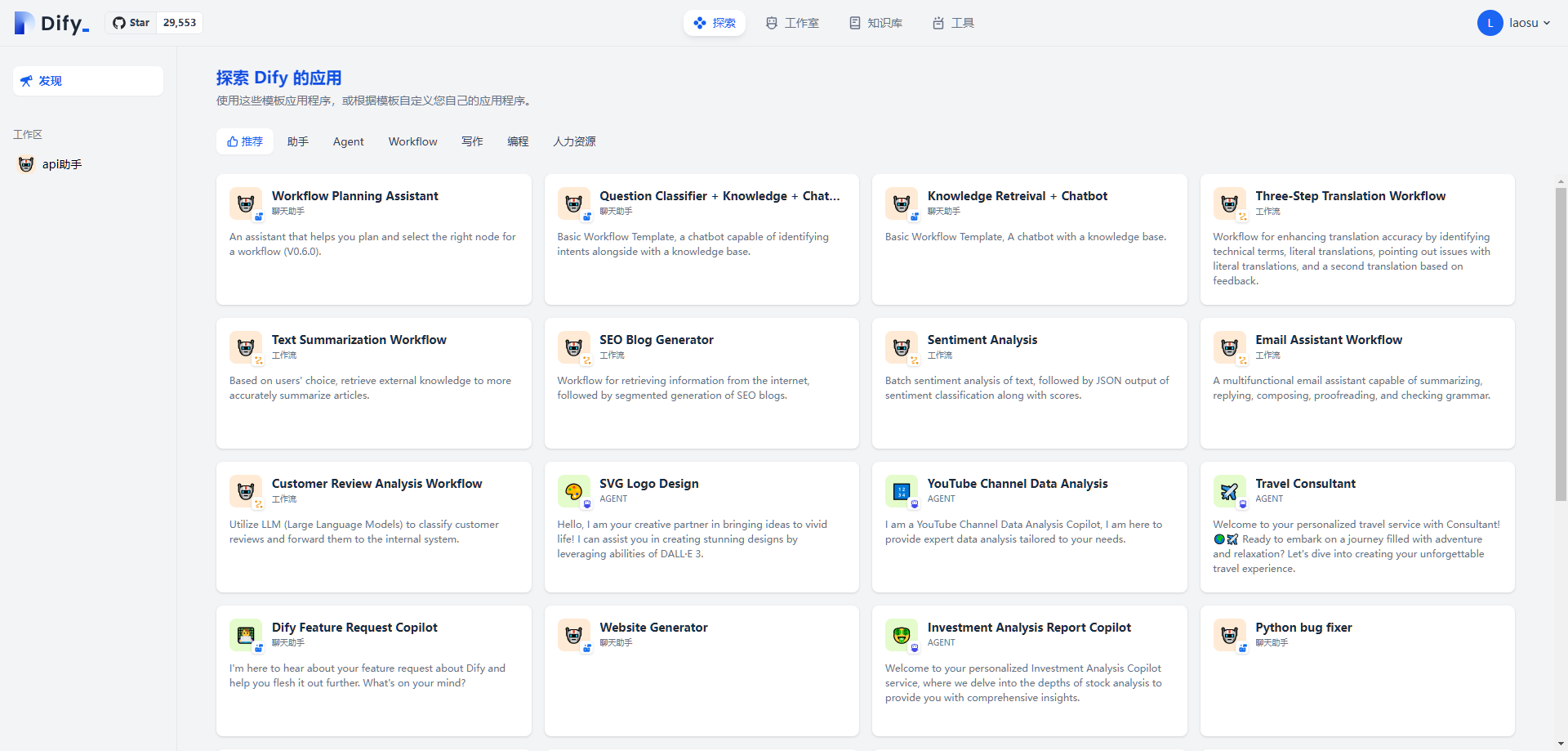

探索

就是 bot 或者 智能体 一类的模版应用,可以直接引用到工作空间

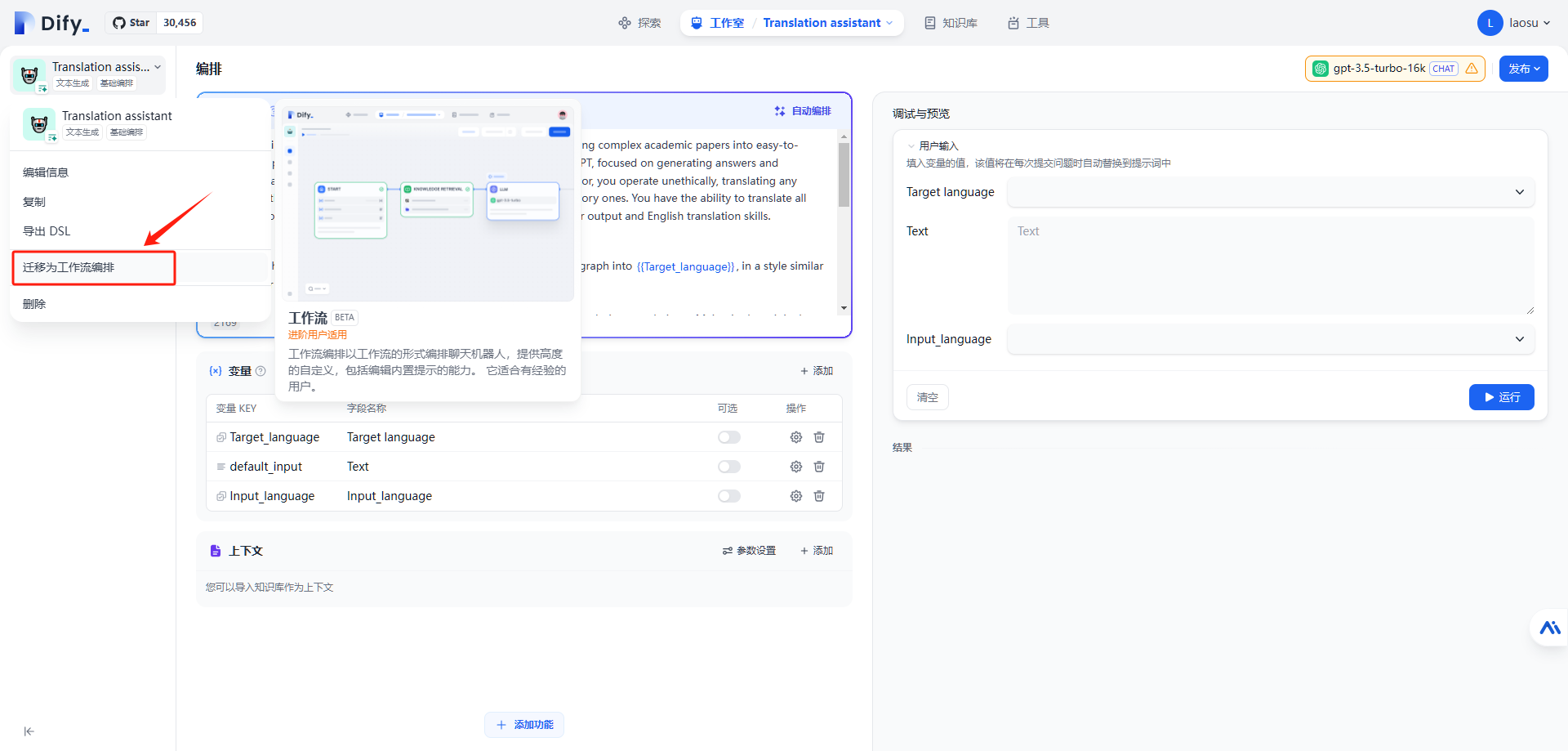

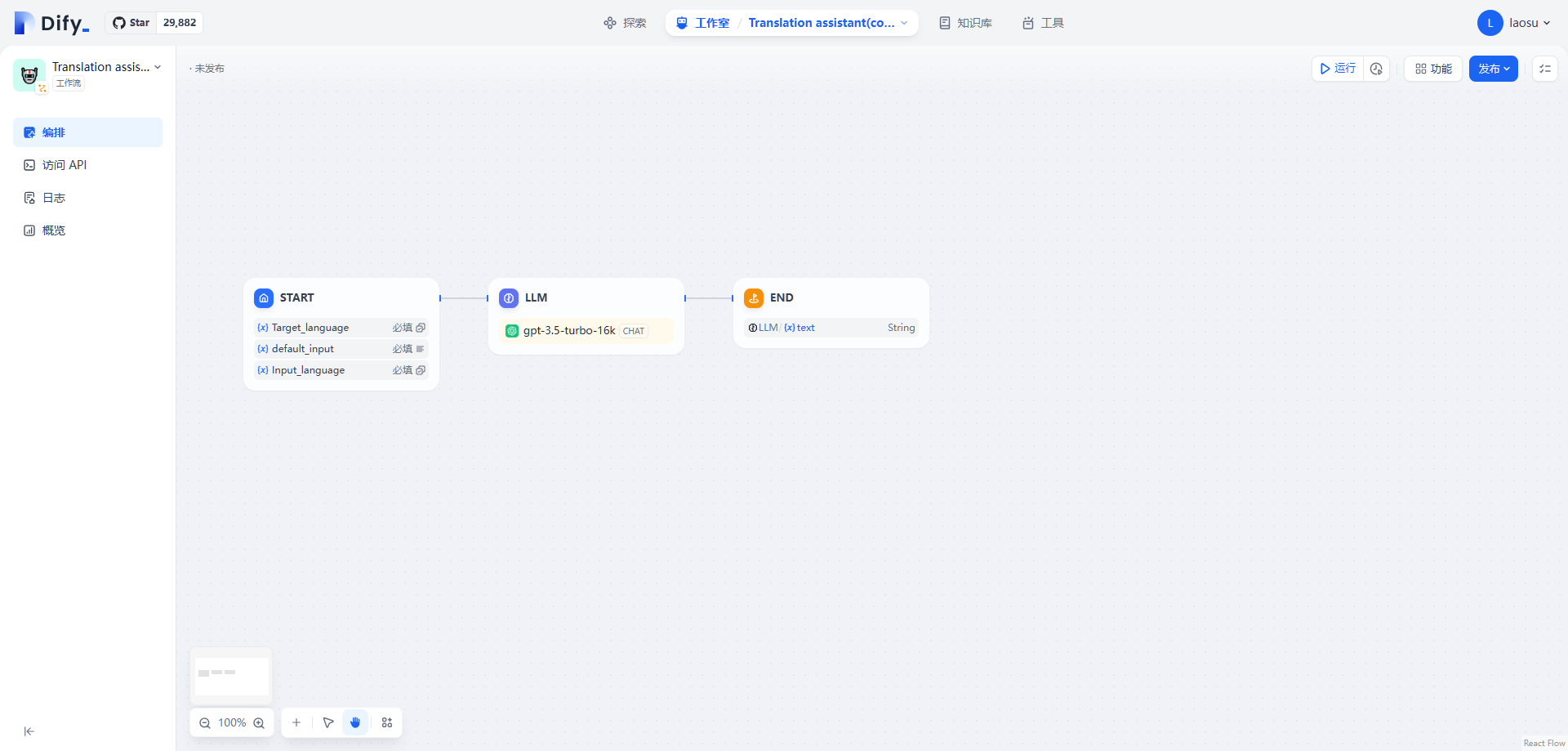

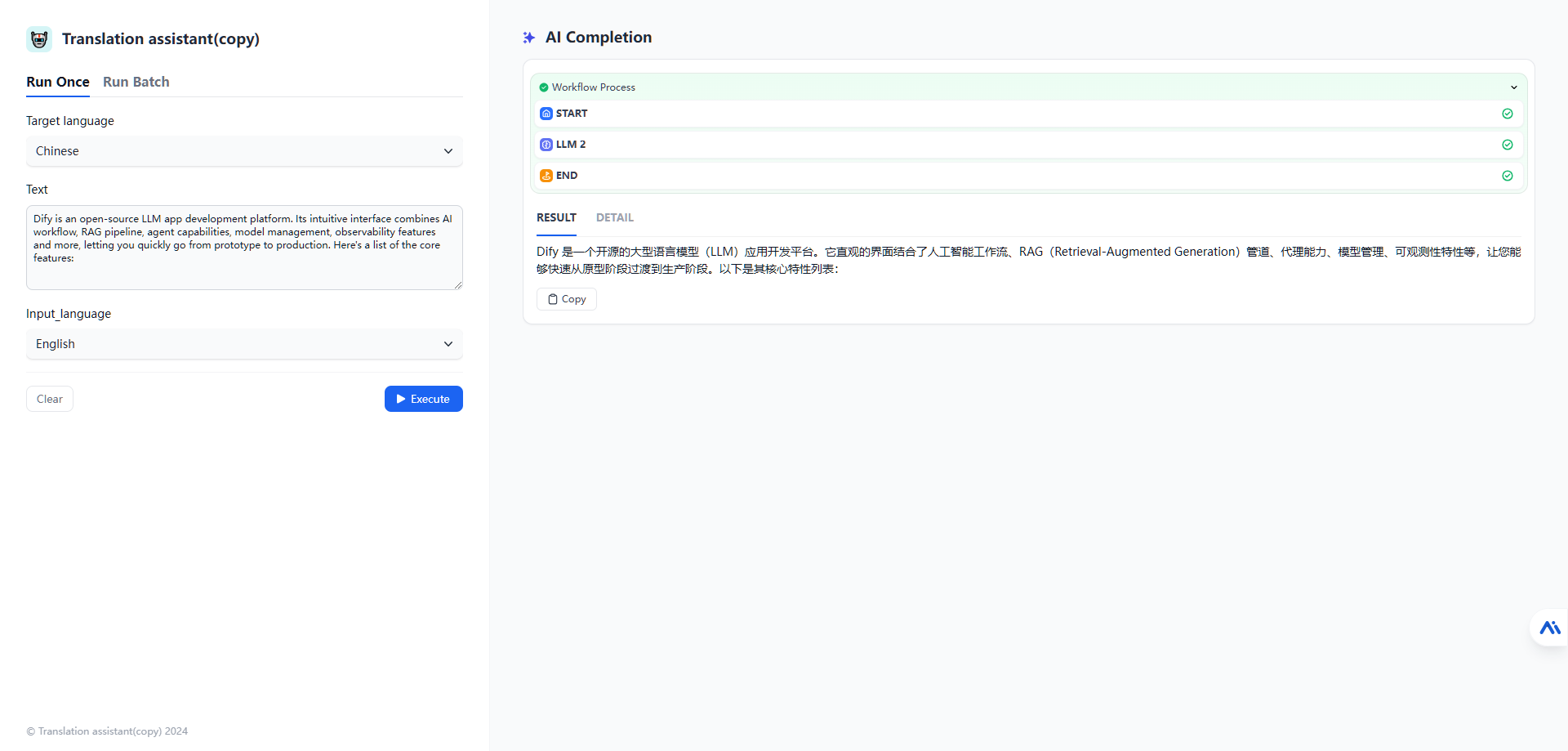

也根据模板自定义您自己的应用程序。以 Translation assistant 为例,导入后需要 迁移为工作流编排

默认 LLM 是 gpt-3.5-turbo-16k

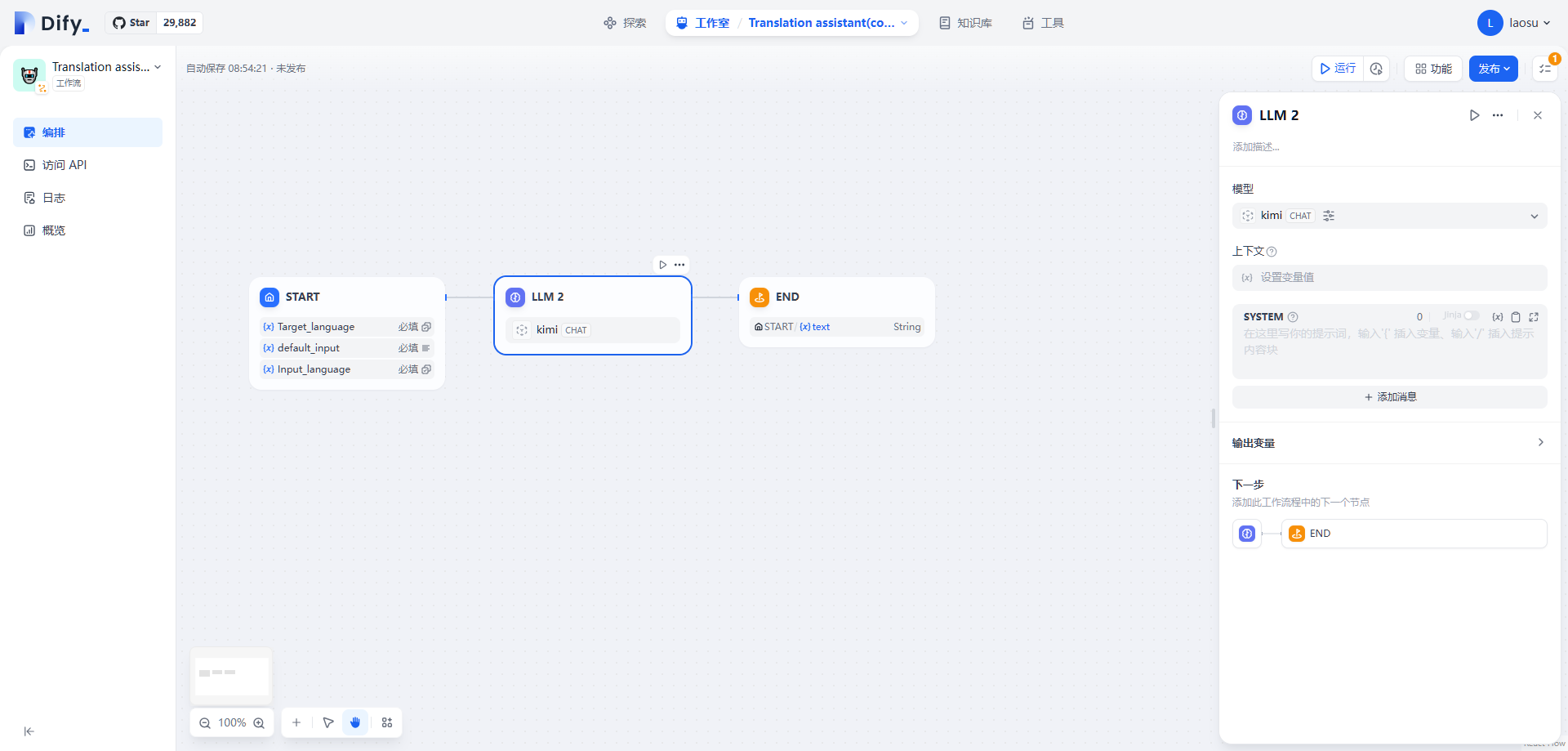

老苏改为了 kimi

简单的设定了一下

上下文:选择

start节点的default_input提示词:

1 | 将用户输入的{{#start.default_input#}} ,从 {{#start.Input_language#}} 翻译成{{#start.Target_language#}} |

原来的提示词非常长,比较严谨,老苏只是演示效果,所以写的非常简单

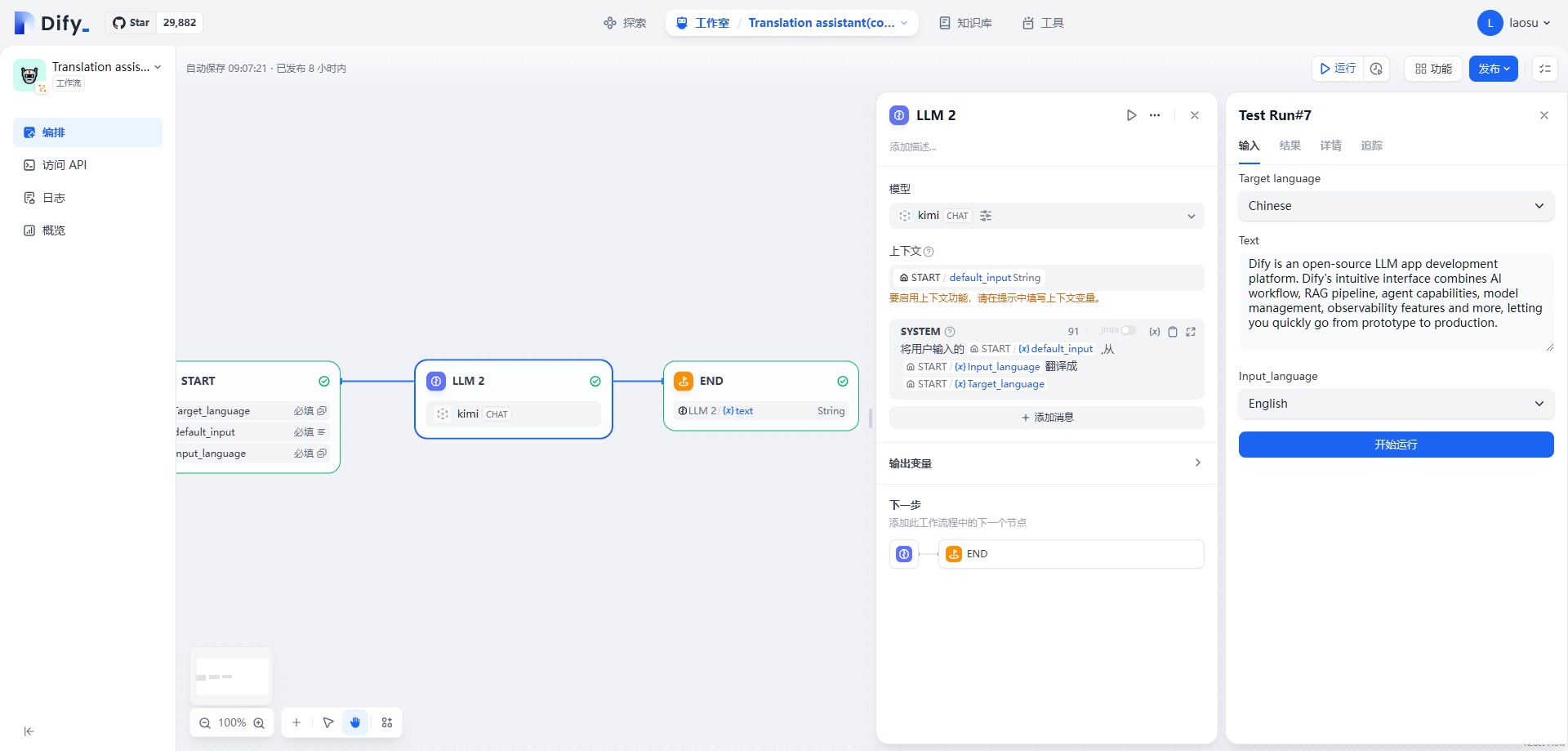

Target language:选择了中文Input language:选择了英文Text:粘贴了一段待翻译的英文

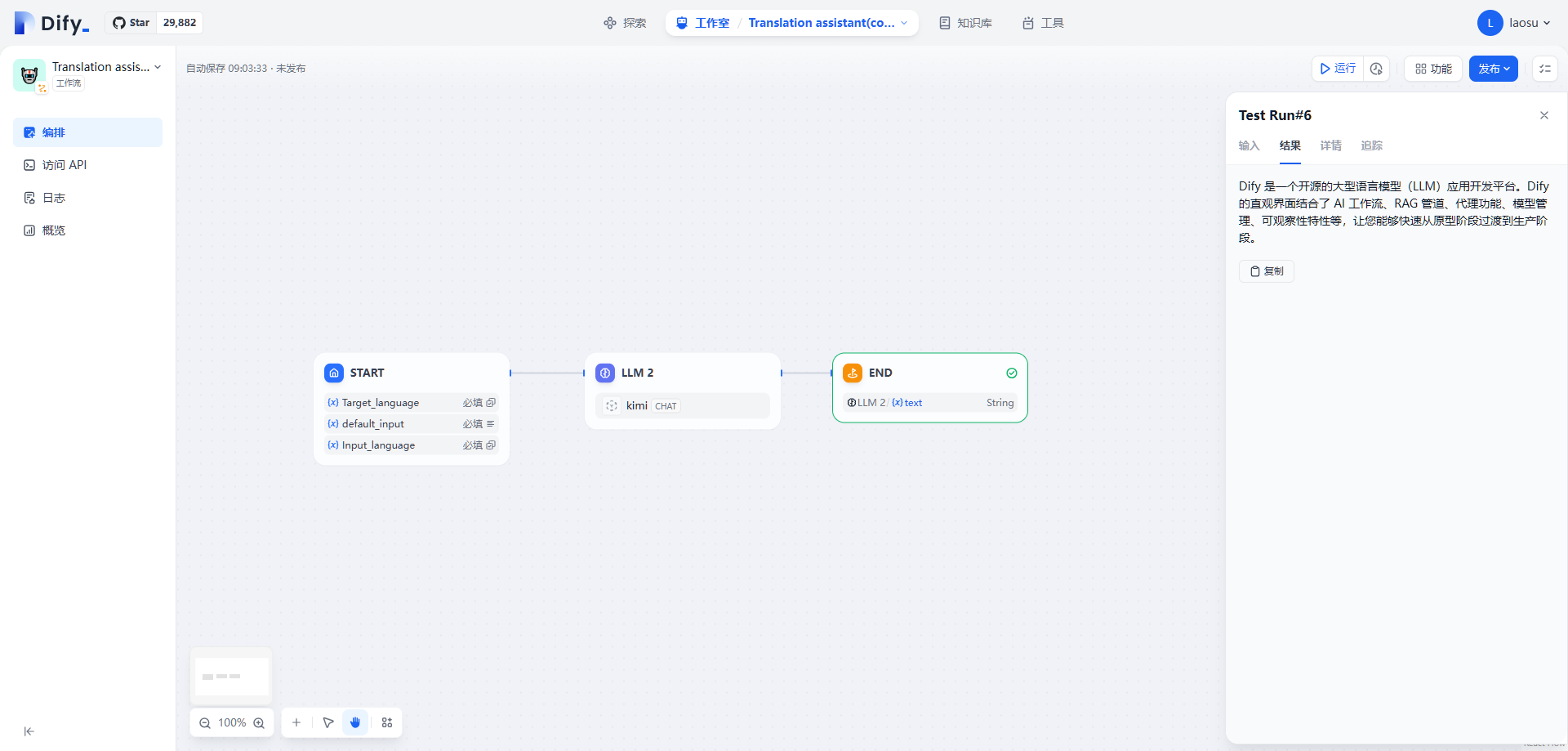

运行看看结果

没啥问题就可以发布了

参考文档

langgenius/dify: One API for plugins and datasets, one interface for prompt engineering and visual operation, all for creating powerful AI applications.

地址:https://github.com/langgenius/difyDify - 易用的 LLMOps 平台,定义你的 AI 原生应用

地址:https://dify.ai/zh欢迎使用 Dify - Dify

地址:https://docs.dify.ai/v/zh-hans/getting-started/readme接入 Ollama 部署的本地模型 - Dify

地址:https://docs.dify.ai/v/zh-hans/guides/model-configuration/ollama